Fasterize tarafından sponsorlu makale

Sistemler giderek daha hızlı evrilirken, SEO ekiplerinin optimizasyonları test etme ve uygulama yeteneği yapısal olarak yavaş kalmaktadır. Bir SEO yol haritasının pazara çıkış süresi artık sadece 12 ayda gerçekleşememektedir: aynı zamanda gerçek zamanlı olarak da harekete geçebilmek gerekmektedir.

Fasterize, SEO ekiplerine teknik deneyleri kolay ve hızlı bir şekilde uygulama imkanı sunarak, sürekli olarak geliştirme kaynaklarını meşgul etmeden hareket etme yeteneği kazandırmaktadır. Bu yeni çeviklik, yanıt motorlarının (ChatGPT, Perplexity, Gemini) çevrimiçi görünürlük kurallarını değiştirdiği bir ortamda daha da önem kazanmaktadır.

LLMs.txt ve İyi Uygulamalar

robots.txt dosyası uzun zamandır tarayıcıların erişimini kontrol etmek için evrensel bir standart olmuştur. Bugün, yapay zeka ajanlarını yönlendirmek için özel olarak tasarlanmış /llms.txt ve /llms-full.txt dosyaları gibi yeni bir konvansiyon ortaya çıkmaktadır. Bu dosyalar, teorik olarak, LLM'lere erişilebilen site bölümleri hakkında net kurallar tanımlamayı, kullanım izinlerini vermeyi veya reddetmeyi ve içerik kullanım hakları hakkında bilgi vermeyi mümkün kılmaktadır.

Fasterize'in EdgeSEO çözümü, algılanan User-Agent'a bağlı olarak bu dosyaları dinamik bir şekilde sunma imkanı sunarak, siteye sorgu yapan botlara göre erişimin daha ayrıntılı bir şekilde yönetilmesini sağlamaktadır. Bu yaklaşım, birden fazla statik dosya oluşturmayı önler ve farklı LLM'lerin uygulamalarındaki değişikliklere göre kuralları gerçek zamanlı olarak uyarlamayı mümkün kılar.

Not: Bu aşamada, deneyim geri bildirimleri LLM'lerin bu tür dosyaları henüz pek dikkate almadığını göstermektedir. Google, özellikle llms.txt dosyasına dayanmadığını belirtmiştir ve diğer modellerin davranışı kullanım bağlamına göre değişebilir.

Bugün, robots.txt dosyası içerik keşfini yönlendirmek için en yaygın olarak tanınan standart olmaya devam etmektedir. Bununla birlikte, her deklaratif mekanizmada olduğu gibi, üçüncü taraf veri setlerinde içeriklerin olası kullanımı konusunda kesin bir garanti sağlamaz (örneğin, Common Crawl gibi kaynaklar aracılığıyla).

Bir llms.txt dosyası oluşturmak, bugün hâlâ büyük ölçüde keşifsel bir girişimdir ve siteniz için risk oluşturmaz. Bu, daha çok test etme ve öğrenme mantığına dayanmaktadır, tam olarak kontrol edilen bir strateji olmaktan ziyade.

Bu aşamada, esasen deney yapmak, modellerin gönderdiği olası sinyalleri gözlemlemek ve gelecekteki gelişmelere yönelik bir pozisyon almak önemlidir; hemen veya garanti bir etki beklemekten ziyade.

Markdown'un Anlam Yoğunluğuna Hizmeti

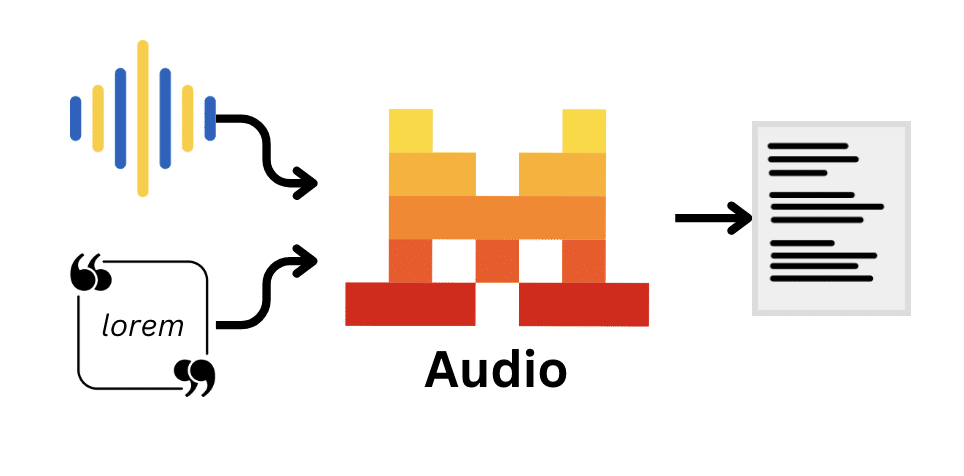

Yapay zeka ajanları, Markdown'u referans formatı olarak benimsemektedir, çünkü bu format, LLM'ler için bazen fazla ayrıntılı olan HTML'den daha hafif, daha okunabilir ve daha hızlı işlenebilir. Geliştiriciler, web içeriğini çıkarmak ve LLM'lere beslemek için Crawl4AI ve Firecrawl gibi araçlar kullanmakta ve ReaderLM-v2 gibi modeller, bu dönüşüm için özel olarak eğitilmektedir.

Prensip, HTML'i anlık olarak Markdown'a dönüştürmek ve yalnızca yapay zeka ajanları için sunmaktır. Bu dönüşüm, LLM'ye saf, yapılandırılmış ve daha az token tüketen bir içerik sunmak için teknik "gürültüyü" (başlıklar, alt bilgiler, scriptler, navigasyon öğeleri) ortadan kaldırır. Bir Amazon ürün sayfasında, ham HTML'den hedeflenmiş Markdown'a geçmek, token hacmini 896.000'den 8.000'in altına düşürmekte, yani %99 tasarruf sağlamaktadır!

EdgeSEO aracılığıyla uygulama oldukça basittir: bir kural, botun User-Agent'ını tanımlayarak yanıt formatını dinamik olarak Markdown'a uyarlamaktadır. Ana avantajı: sayfalarınızın iki ayrı versiyonunu korumanıza gerek yoktur. Klasik HTML sayfanızı değiştiriyorsunuz ve bu sayfa otomatik olarak yapay zeka botları için Markdown olarak güncelleniyor, böylece içerik çoğaltma veya senkronizasyon riski ortadan kalkıyor.

Dinamik SSS Enjeksiyonu: RAG için Doğal Dil

Soru/Cevap formatı, GEO'nun temelini oluşturmuş, çünkü bu format, LLM'lerin kullandığı RAG (Retrieval-Augmented Generation) mimarisiyle mükemmel bir uyum içindedir. RAG sistemleri, modelin bağlamını beslemek için ilgili bilgi parçalarını geri alır ve SSS formatı, bu süreç için bilgiyi doğal olarak en iyi şekilde yapılandırır.

Yöntem, stratejik sayfalara dinamik olarak bağlamlandırılmış SSS blokları enjekte etmek ve özellikle yüksek trafik alanlarını hedeflemektir. Bu dinamik enjeksiyon, kullanıcı deneyimini ağırlaştırmadan içeriği zenginleştirmekte ve sayfayı ziyaretçinin insan mı yoksa yapay zeka ajanı mı olduğuna göre uyarlamaktadır.

Dikkat edilmesi gereken bir nokta: enjekte etmek için enjekte etmemek gerekir. Her SSS, gerçek bir "Zero-click" arama niyetine cevap vermeli, yani kullanıcıların gerçekten sorduğu bir soruya doğrudan ve eksiksiz bir yanıt sağlamalıdır. Amaç, içerikleri yapay olarak şişirmek değil, mevcut bilgiyi yapılandırarak LLM'lerin yanıtlarında alıntı yapılma olasılığını maksimize etmektir.

Gömülü Widget Tuzaklarından Çıkmak: "Sert" İncelemelerin Enjeksiyonu

LLM'ler genellikle, kritik E-E-A-T (Deneyim, Uzmanlık, Yetkinlik, Güvenilirlik) unsurları gibi müşteri incelemeleri Trustpilot gibi içerikleri, ana DOM'dan izole bir bağlam yarattıkları için, iFrame ve JS widget'larının içeriğini göz ardı etmektedir. JavaScript ile yazılmış olan bu unsurlar, yapay zeka ajanlarının "gözlerinden" görünmez hale gelmektedir.

Buradaki çözüm, incelemeleri API aracılığıyla almak ve doğrudan kaynak koduna enjekte etmek için EdgeSEO kullanmaktır; bu, sayfa tarayıcıya sunulmadan önce gerçekleşmektedir. Sunucu tarafında bu enjeksiyon, içeriğin LLM'ler tarafından ayrıştırılan ilk HTML'de mevcut olmasını garanti eder ve bazı yapay zeka ajanlarının çalıştıramayacağı karmaşık JavaScript render'ını beklemez.

Doğrudan etkisi, LLM'lerin öneri algoritmaları gözünde E-E-A-T'nin önemli bir şekilde güçlenmesidir. Müşteri incelemeleri, sosyal kanıt ve kullanıcı uzmanlığı sunarak, modellerin alıntı ve öneri süreçlerinde yüksek değer taşıyan unsurlardır. Bu içeriği ham HTML içinde doğrudan erişilebilir hale getirerek, yanıt oluşturma süreçlerinde görünme şansınızı mekanik olarak artırıyorsunuz.

Webperformansı ve Yapay Zeka Tarama Bütçesi: Gecikmenin Etkisi

Yapay zeka araçları tarafından belirtilen 2.138 web sitesinin analizi, teknik performans ile yanıt oluşturmadaki görünürlük arasında doğrudan bir korelasyon olduğunu ortaya koymaktadır. Core Web Vitals, geleneksel SEO için zaten önemliyken, GEO için iki kat kritik hale gelmektedir, çünkü bunlar LLM botlarının içeriğinizi çıkartma ve alıntı yapma yeteneğini etkilemektedir.

Salt Agency'nin çalışmasından elde edilen veriler, mükemmel bir şekilde ölçülebilir korelasyonları göstermektedir:

- CLS ≤ 0,1 olan siteler, bu eşiği aşan sitelere göre, oluşturulan özetlerde %29,8 daha yüksek bir dahil olma oranı kaydetmektedir.

- LCP'si ≤ 2,5 saniye olan sayfalar, daha yavaş olan sayfalara göre 1,47 kat daha fazla IA çıktılarında görünme olasılığına sahiptir.

- HTML'i 1 MB'yi aşan sayfaların tarayıcılar tarafından %18 oranında terk edildiği gözlemlenmektedir; bu da temiz bir işaretleme benimsemenin gerekliliğini vurgulamaktadır.

- Son olarak, 200 ms'den daha düşük bir TTFB (İlk Bayt İçin Geçen Süre), alıntı yoğunluğunda %22'lik bir artış ile ilişkilidir; bu, sağlam önbellekleme stratejileri ile bir araya geldiğinde özellikle geçerlidir.

Bu nokta kritik: LLM botları insanlar gibi gezinmez. HTML'ye erişim hızını, okunabilirliğini ve kullanılabilirliğini hızlı bir şekilde değerlendirirler. Yüksek bir gecikme, keşfedilen sayfa sayısını mekanik olarak azaltır ve dolayısıyla alıntı olasılığını düşürür.

İşte bu noktada EdgeSpeed devreye girmektedir: TTFB'yi önemli ölçüde azaltarak ve yanıt sürelerini dengeleyerek, yapay zeka botları tarafından gerçekten kullanılabilir sayfa sayısını artırmaktadır.

EdgeSpeed'in getirdiği ek yük, marjinaldir (ortalama 10-15 ms) ve HTML'in hafifletilmesi ile LLM tarafında ayrıştırmanın optimize edilmesi ile büyük ölçüde telafi edilmektedir.

Dinamik Render ile Cloaking: Formatı Aldatmadan Uyarlamak

Bir site mükemmel Core Web Vitals gösterebilir, ancak yine de LLM'lerden görünmez kalabilir. Neden? Çünkü ana içeriği, yapay zeka botlarının çalıştıramayacağı bir JavaScript'e bağlıdır. Bu teknik gerçeklik, şu geçerli soruyu gündeme getirir: İçeriğinizi arama motoru kurallarını ihlal etmeden yapay zeka ajanlarına nasıl erişilebilir hale getirebilirsiniz?

İyi haber: Google ayrım yapmaktadır. Mountain View'deki dev, dinamik render'ı cloaking olarak görmemektedir; sunulan içerik benzer kaldığı sürece. Fark, niyette yatmaktadır: farklı bir içeriği gizlemek değil, içeriği müşterinin teknik yeteneklerine göre uyarlamaktır. Botlar için "veri yoğun" bir versiyon, erişilebilir yapılandırılmış bilgiyi maksimize ederken, insanlar için "UX yoğun" bir versiyon görsel ve etkileşimli deneyimi önceliklendirir.

EdgeSEO, tam olarak bu yaklaşımı kolaylaştırarak User Agent'ı tespit etmeyi ve içeriğin teslim formatını otomatik olarak uyarlamayı mümkün kılmaktadır. Somut olarak, önceden yüklenmiş içerikleri (örneğin, gömülü widget'lar veya API aracılığıyla) HTML'e yeniden enjekte ederek, zengin bir kullanıcı deneyimi sağlarken, zenginleştirilmiş metin versiyonunu sunabilirsiniz. Bu yaklaşım, birçok LLM'nin (Claude ve bazı Perplexity sürümleri) JavaScript'i çalıştıramadığı ve tam bir tarayıcı gibi değil, ham HTML'i okuyan scraper gibi davrandığı göz önüne alındığında özellikle önemlidir.

Uyumlu kalmanın altın kuralı: Yapay zeka ajanlarına sunulan içerik, kullanıcı versiyonundaki bilgilere sadık ve eksiksiz bir temsil olmalıdır; yalnızca yapısında ve sunum formatında teknik bir uyarlama ile. Gizli metin yok, ek anahtar kelimeler yok, farklı bilgiler yok; yalnızca yapay zeka tarayıcılarının sınırlamalarını aşmak için teknik bir uyarlama. Dikkat edilmesi gereken nokta: Google, 2022'den bu yana dinamik render'ı uzun vadeli bir çözüm olarak önermemektedir; Server-Side Rendering (SSR) tercih edilmektedir. Ancak, 2026'da birçok LLM botunun hâlâ JavaScript çalıştıramadığı GEO'nun özel bağlamında, EdgeSEO, en önemli içeriklerin kaynak koduna geri getirilmesi için stratejik bir araçtır; böylece bu içerikler botlar tarafından doğru bir şekilde kullanılabilir hale gelir!

Yorumlar

(4 Yorum)